« Vous n’aurez pas ma liberté de penser » affirmait Florent PAGNY,

faisant de l’esprit le dernier refuge des libertés individuelles. Il avait tort !

Connaître la pensée d’autrui et même la coloniser c’est aujourd’hui possible avec le développement spectaculaire des neurotechnologies. Il y a deux ans, la BBC révélait avoir expérimenté un contrôle du téléviseur par la pensée, permettant aux zappeurs fous de changer de chaîne sans même avoir besoin de leur télécommande. En médecine, il était déjà possible de mouvoir un bras artificiel à l’aide d’électrodes implantées dans le cerveau et un logiciel apte à décoder les pensées du patient. L’Université de Stanford a publié il y a deux mois les résultats d’une étude qui consistait à placer des capteurs dans le cerveau de quelques personnes atteintes de déficiences de la moelle épinière ou souffrant de la maladie de Charcot. En se concentrant, ces personnes ont été capables de déplacer mentalement un curseur sur un écran représentant un clavier virtuel et de former huit mots en une minute.

La technique s’appuie sur le captage des signaux électriques produits par le cerveau. Ces impulsions sont entrées dans un ordinateur qui les traite pour reconstruire les sons des mots que les patients pensent. Mais dès lors, le processus peut être inversé. Un article de novembre 2016 du Guardian exposait l’état de l’expérimentation militaire pour « assister » le cerveau en situation de stress important sur des théatres d’opération. Il ne fallait donc qu’un pas pour que les grandes entreprises s’y intéressent. Il est franchi. Il y a quelques mois, Elon MUSK, le patron multimilliardaire de TESLA et SPACE-X, qui avait pourtant qualifié l’intelligence artificielle de « pire menace » pour l’humanité en 2014, a annoncé fin 2016 la création de Neurolink, sa dernière filiale dédiée à la capture des données neuronales pour permettre leur transfert aux appareils numériques : « Je pense que nous aurons une interface cérébrale qui fonctionne dans quatre ou cinq ans », promet-il. Et le 18 avril dernier lors de la conférence annuelle des développeurs, un autre géant, Facebook, a annoncé travailler sur un projet identique visant à transcrire en texte les pensées en temps réel.

« Je pense que nous aurons une interface cérébrale qui fonctionne dans quatre ou cinq ans » Elon Musk

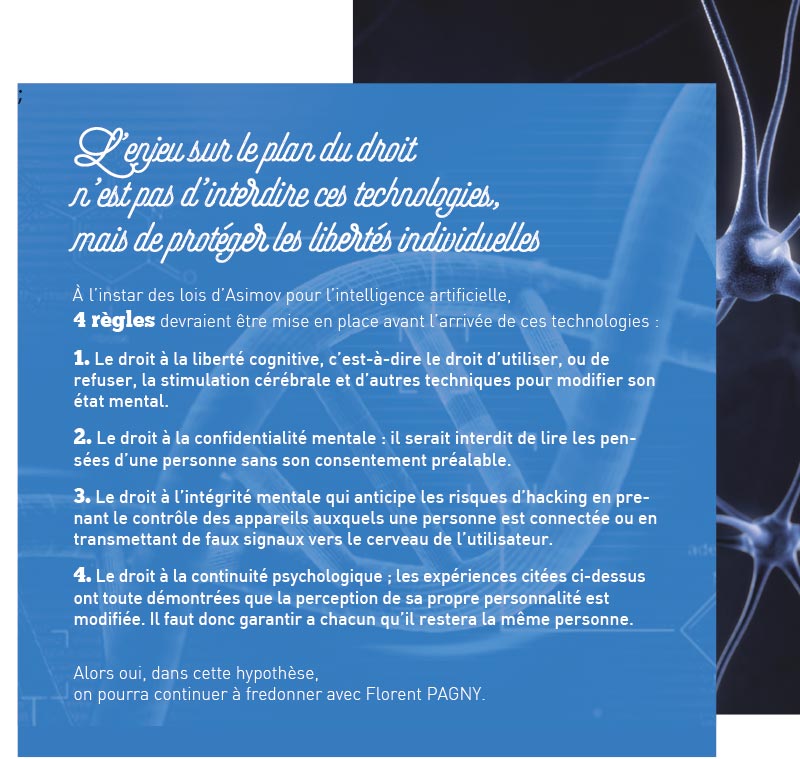

Dans cette course de vitesse, Facebook a constitué une équipe de plus de 60 scientifiques et ingénieurs, spécialisés dans le langage, les systèmes d’imagerie cérébrale et les prothèses neurologiques. L’objectif est clair : créer en moins de deux ans un système capable de décoder des mots dans la partie du cerveau qui héberge le centre du langage, et à les transcrire directement sur un ordinateur à la vitesse de 100 mots par minute, soit 5 fois plus vite que le temps nécessaire aujourd’hui pour les taper sur un écran tactile de smartphone. Ces ruptures scientifiques portent avec elles des interrogations vertigineuses sur la place de l’être humain dans son environnement. Comment se protéger pour éviter que nos informations cérébrales soient volées, détournées, ou hackées, ou pire encore, que le cerveau puisse être contrôlé ? Comment être certain que ne seront pas mise en place la collecte de nos signaux, la transmission d’instructions subliminales au cerveau, ou encore la captation d’autres pensées ? Facebook assure fermement que telles ne sont pas ses intentions et que, bien sûr, elle appliquera en ce domaine l’éthique la plus scrupuleuse : « il ne s’agit pas d’espionner toutes nos pensées » mais d’identifier les mots que nous voulons activement partager avant qu’ils ne deviennent un son. Mais lorsque qu’une entreprise comme Facebook se veut rassurante et affirme qu’il ne s’agira en aucun cas d’espionner, on ne peut s’empêcher de penser que c’est précisément de cela qu’il s’agit. Cette entreprise a montré par le passé comment elle traitait et vendait les données personnelles.

Article écrit par Franck ROYANEZ, avocat au Barreau de Nouméa et membre du Réseau LEXING, présent dans trente pays et spécialisé dans le droit des nouvelles technologies.